注意力机制的序列标注 Sequence-Label-Attention 注意力机制的序列标注

”注意力机制 序列标注 attention 深度学习“ 的搜索结果

大白话解析注意力机制

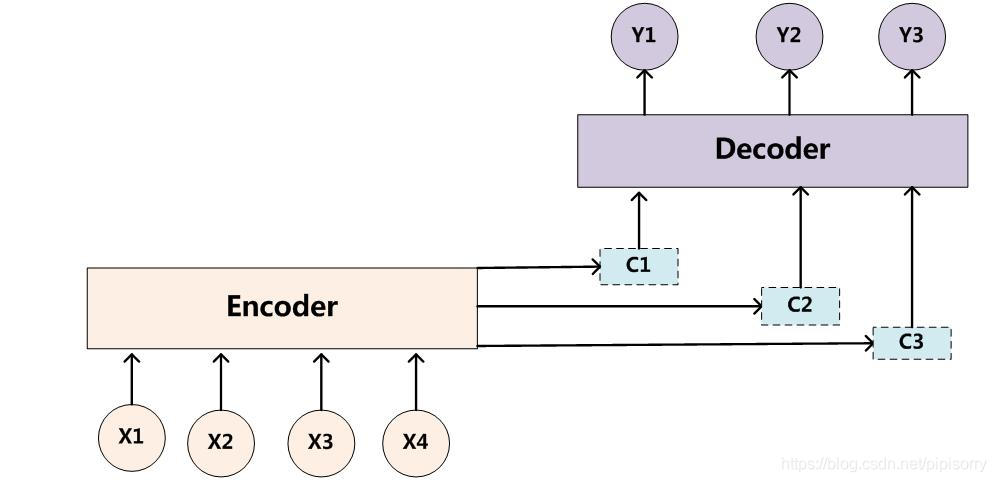

一、注意力机制和自注意力机制的区别Attention机制与Self-Attention机制的区别传统的Attention机制发生在Target的元素和Source中的所有元素之间。简单讲就是说Attention机制中的权重的计算需要Target来参与。即在...

[【基于多层次注意力机制的深度学习模型设计方法研究】: 研究基于多层次注意力机制的深度学习模型设计方法](https://img-blog.csdnimg.cn/direct/3e71d6aa0183439690460752bf54b350.png) # 1. 深度学习模型设计方法...

一、注意力机制和自注意力机制的区别Attention机制与Self-Attention机制的区别传统的Attention机制发生在Target的元素和Source中的所有元素之间。简单讲就是说Attention机制中的权重的计算需要Target来参与。即在...

一文带你读懂注意力机制、自注意力机制、多头注意力机制、通道注意力机制、空间注意力机制,超详细的讲解,小白也能看得懂!

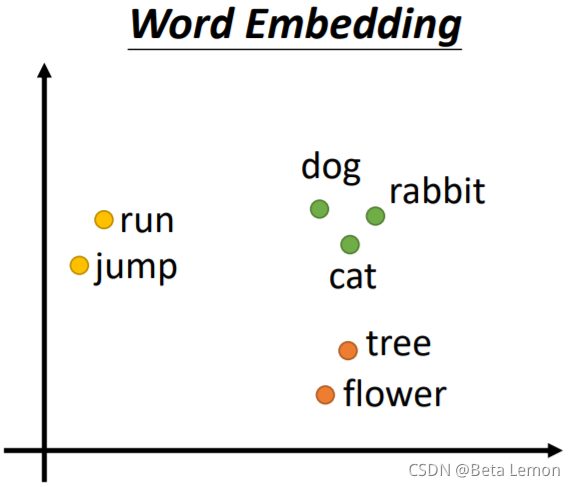

理解深度学习中的注意力机制 在深度学习领域,注意力机制是一种重要的模型结构,它在提升模型性能和精度方面发挥着关键作用。通过对数据的不同部分赋予不同的注意权重,注意力机制可以使模型集中精力处理关键信息...

## 1.1 介绍注意力机制在深度学习中的重要性 注意力机制是深度学习领域中一种重要的模型,它可以帮助模型更加专注于输入数据中的关键部分,有效提升模型的性能。通过引入注意力机制,模型能够有选择性地关注输入中...

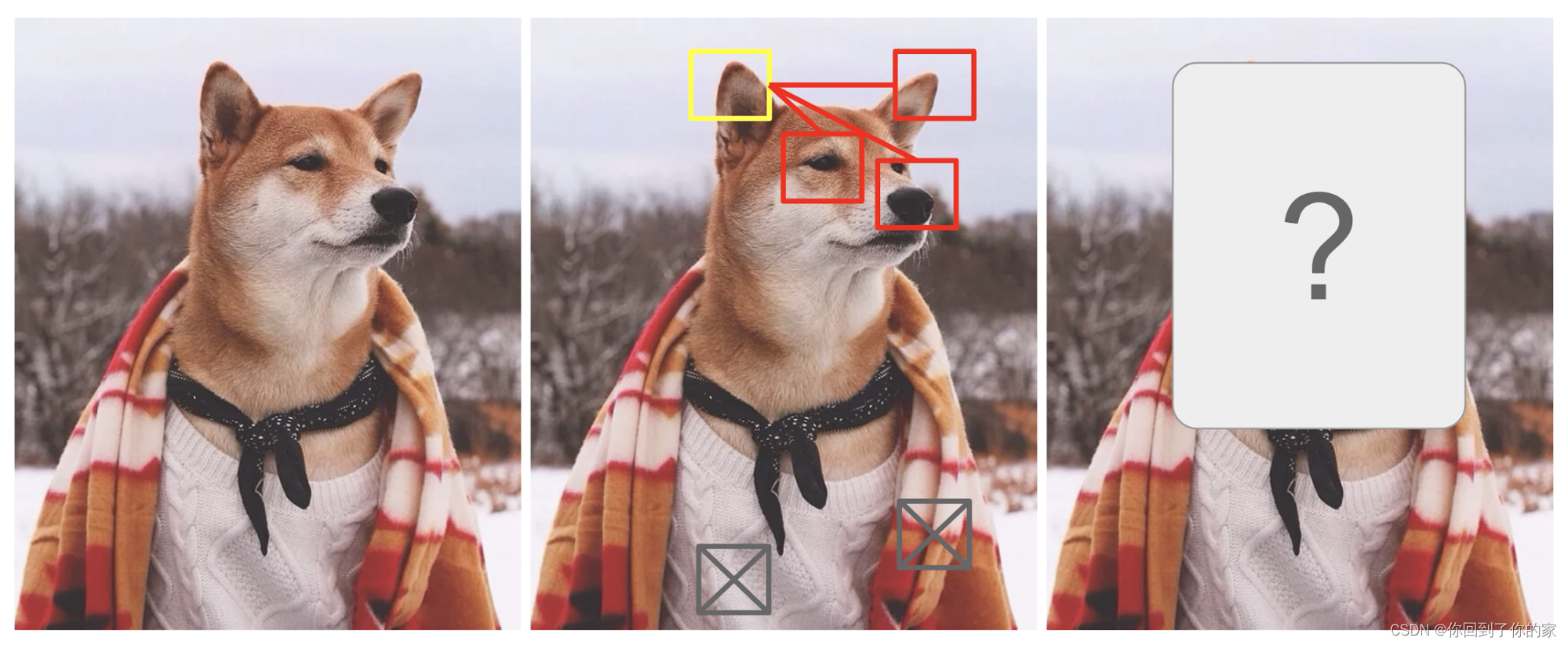

1.背景介绍 计算机视觉是人工智能领域的一个重要分支,它涉及到计算机对图像和视频等二维和三维数字...本文将从卷积神经网络到注意力机制,详细介绍深度学习在计算机视觉中的应用和实现。 2.核心概念与联系 2.1 ...

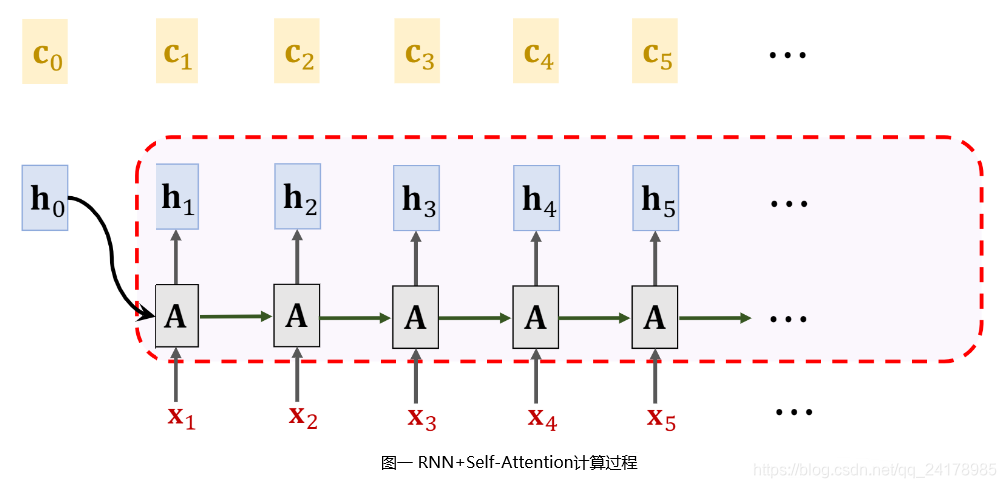

# 1. 简介 ### 1.1 背景介绍 在自然语言处理(Natural Language Processing,简称NLP)领域中,序列标注是一种...本文旨在探讨如何利用长短时记忆网络(Long Short-Term Memory,简称LSTM)和注意力机制(Attention)

转载地址 实战博客地址 ...2017 年中,有两篇类似同时也是笔者非常欣赏的论文,分别是 FaceBook 的 Convolutional Sequence to Sequence Learning 和 Google 的 Attention is All You Need,...

注:本文为开源内容,部分标注了个人理解,仅为个人学习记录,无抄袭搬运意图。

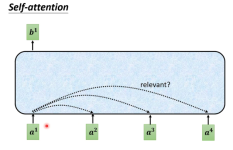

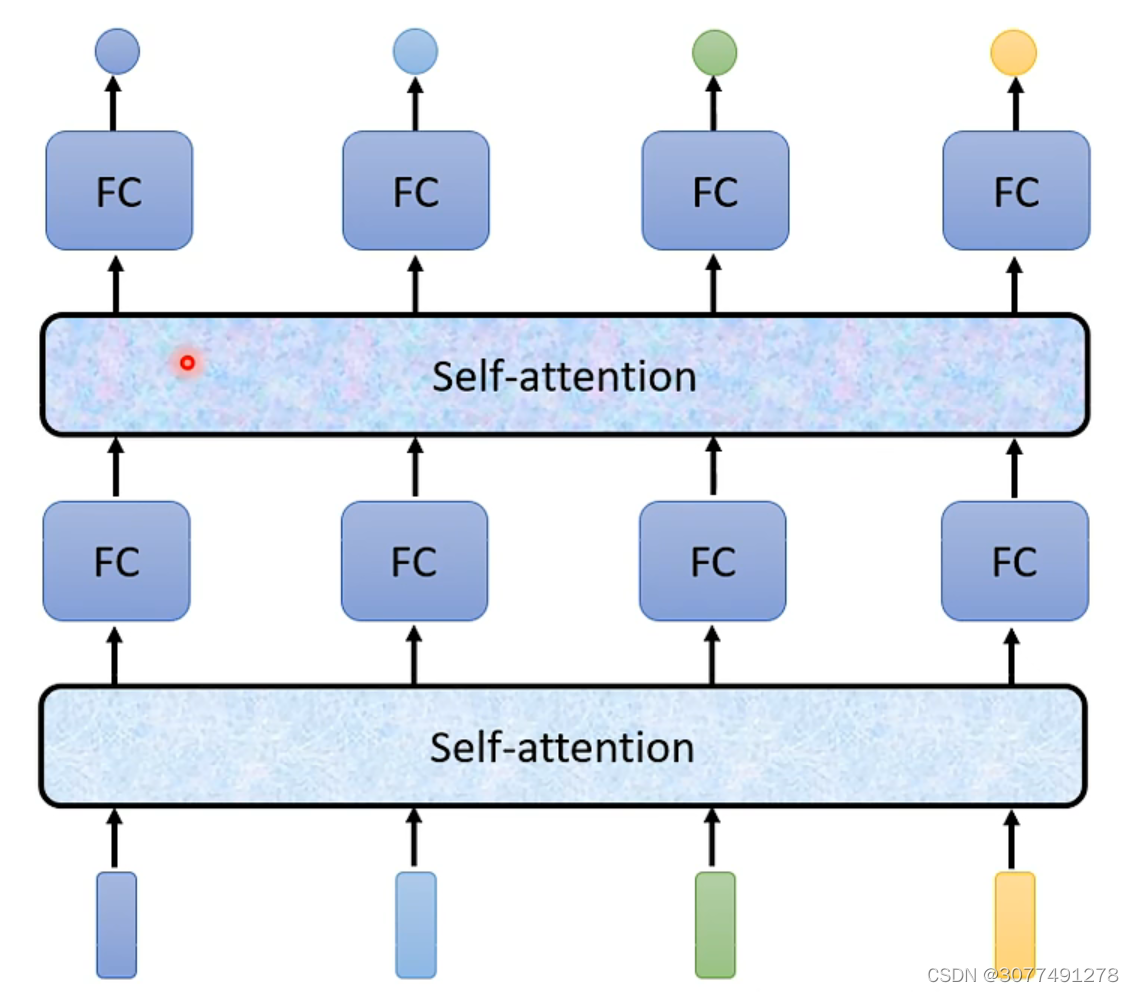

在self-attention中,a1与a2,a3,a4分布计算相关性,把a1乘以wq得到q1(q有个名字叫query),a2乘以wk得到k2(k称之为key),然后q1与q2做点积得到α1,2(老师课程中说的是inner product,推测是口误了),α1,2称为...

自注意力机制(Self-Attention),有时也称为内部注意力机制,是一种在深度学习模型中应用的机制,尤其在处理序列数据时显得非常有效。它允许输入序列的每个元素都与序列中的其他元素进行比较,以计算序列的表示。...

推荐文章

- python入门(13)异常与文件_except filenotfounderror:-程序员宅基地

- Android面试攻略_详细了解在当今的社会里android工程师应具备什么的技能?并能详细说说自己的见解。-程序员宅基地

- Zendframework 1.6整合Smarty_setting private or protected class member is not a-程序员宅基地

- Qt-装饰者模式_qt装饰模式-程序员宅基地

- 新开普掌上校园服务管理平台service.action RCE漏洞复现 [附POC]-程序员宅基地

- 基于 Milvus 的音频检索系统-程序员宅基地

- 331、基于51单片机智能红外遥控暖风机温度无线蓝牙远程控制系统设计(程序+原理图+配套资料等)_红外感应暖风机自动控制系统设计-程序员宅基地

- Android自定义圆角矩形图片ImageView_android 矩形圆角imageview-程序员宅基地

- 又见回文 字符串-程序员宅基地

- switch的参数可以是什么类型?_switch的参数有哪些-程序员宅基地